Gubernur California Gavin Newsom menandatangani dua undang-undang pada hari Minggu untuk melindungi anak di bawah umur dari gambar seksual anak-anak yang berbahaya yang diciptakan melalui penyalahgunaan alat kecerdasan buatan.

Para pendukung RUU ini berargumentasi bahwa undang-undang saat ini akan memperbolehkan jaksa wilayah untuk menuntut mereka yang memiliki atau mendistribusikan gambar-gambar pelecehan seksual terhadap anak-anak yang dibuat oleh AI jika mereka tidak dapat membuktikan bahwa materi tersebut menggambarkan orang sungguhan. Di bawah undang-undang baru, kejahatan semacam itu akan dianggap sebagai kejahatan berat.

Bulan lalu, Newsom menandatangani undang-undang untuk mengatur konten pemilu “deepfake” yang dihasilkan oleh AI dan mewajibkan penghapusan “konten yang menipu” dari media sosial. Undang-undang ini saat ini sedang digugat di pengadilan.

Kantor gubernur mengatakan undang-undang baru ini merupakan lanjutan dari undang-undang yang disahkan beberapa tahun lalu yang mengatur periklanan dan komunikasi kampanye.

Undang-undang pemilu palsu Newsom telah digugat di pengadilan federal

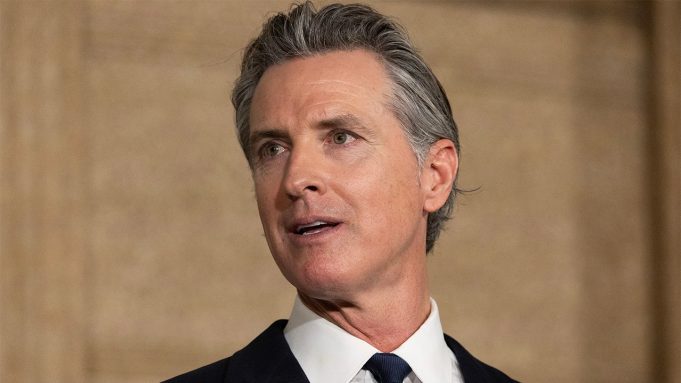

Newsom menyebut California sebagai negara yang mengadopsi dan mengatur teknologi AI. (Myung J. Chun/Los Angeles Times, melalui Getty Images, File)

Undang-undang melarang pembuatan dan publikasi deepfake sebelum Hari Pemilu dan 60 hari setelah Hari Pemilu. Langkah ini juga akan memungkinkan pengadilan menghentikan distribusi materi dan menjatuhkan hukuman perdata, menurut Associated Press.

Newsom juga menandatangani dua rancangan undang-undang lain yang bertujuan melindungi perempuan dan gadis remaja dari pornografi balas dendam, eksploitasi seksual, dan pelecehan yang dimungkinkan oleh alat AI.

KLIK DI SINI UNTUK MENDAPATKAN APLIKASI FOX NEWS

Newsom memuji California sebagai negara yang pertama kali mengadopsi dan mengatur teknologi AI, bahkan ketika negara bagian tersebut mempertimbangkan peraturan baru yang melarang diskriminasi AI dalam praktik perekrutan. Ia mengatakan alat AI generatif dapat segera diperkenalkan untuk mengatasi kemacetan jalan raya dan memberikan panduan perpajakan.

Jamie Joseph dari Fox News dan The Associated Press berkontribusi pada laporan ini.